Monitoreo de alarmas e inteligencia artificial conforman hoy la pregunta que define el futuro del sector: ¿puede una IA recibir una señal, verificarla, interpretarla y comunicarse directamente con la policía para activar un operativo? Durante décadas, el monitoreo estuvo íntimamente ligado al factor humano: operadores, protocolos, llamadas telefónicas, criterios subjetivos y decisiones tomadas en tiempo real. Pero con la irrupción de la IA en cada etapa del proceso, el límite entre asistencia algorítmica y acción autónoma comienza a desdibujarse.

La posibilidad de que una IA reemplace al operador en la verificación y en la llamada al 911 ya no pertenece a la ciencia ficción. La tecnología para hacerlo existe. Lo que todavía no existe es la regulación que permita autorizarlo.

La tecnología ya está madura para asumir el proceso completo

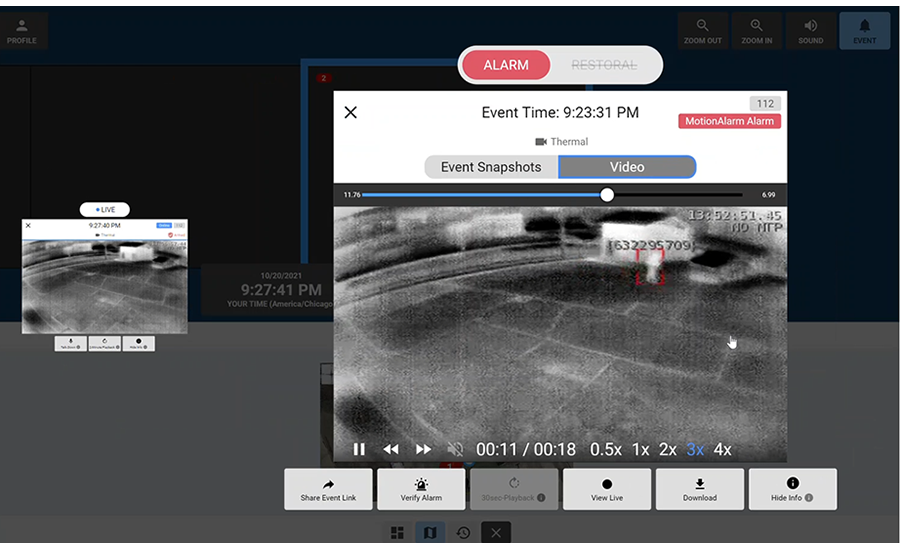

El monitoreo moderno funciona sobre un flujo conocido: recepción de señales, verificación, clasificación, llamado al cliente, validación del evento y posterior contacto con la policía. En ese circuito, la IA ya desempeña funciones críticas. Sistemas avanzados clasifican señales, detectan patrones anómalos, identifican eventos redundantes, filtran falsas alarmas y priorizan incidentes. Plataformas de análisis predictivo ya pueden distinguir entre una apertura normal, una intrusión posible, una falla técnica o un intento de sabotaje.

En paralelo, muchos centros de emergencia a nivel internacional utilizan IA como apoyo operativo: sintetizando información de llamadas, organizando datos, sugiriendo decisiones y optimizando tiempos de respuesta. Incluso robots y sistemas autónomos ya operan en entornos industriales, realizando tareas básicas de vigilancia, rondas, supervisión y reporte sin intervención humana.

Si se considerara únicamente la capacidad técnica, no hay dudas de que una IA podría recibir una señal, verificar su validez, estimar la criticidad y tomar acción. La parte tecnológica del problema está prácticamente resuelta. Lo que no está resuelto es quién asume la responsabilidad cuando esa IA toma la decisión.

Monitoreo de alarmas e inteligencia artificial: El obstáculo real no es técnico, es legal y ético

El proceso de contacto policial en una alarma no es solo un trámite operacional. Es un acto de responsabilidad. Implica activar recursos públicos, afectar tiempos de respuesta, intervenir sobre un domicilio y eventualmente influir en el resultado de un incidente real. Es un acto que siempre tuvo una firma humana detrás.

Si una IA llama a la policía sin justificación, ¿quién es responsable?

Si no llama cuando debe hacerlo, ¿quién responde por los daños?

¿El fabricante del software? ¿La central de monitoreo? ¿El operador que ya no participa? ¿La aseguradora? ¿El Estado que autorizó el sistema?

La seguridad pública está construida sobre trazabilidad, auditoría y responsabilidad humana. Reemplazar esa pieza por un algoritmo obliga a reescribir el marco jurídico, las políticas de aseguramiento y los criterios de certificación. Hasta que eso no exista, ningún país habilitará a una IA a realizar acciones policiales autónomas, por impecable que sea la tecnología.

La cultura institucional también frena el cambio

Los marcos regulatorios latinoamericanos aún discuten aspectos básicos: homologación de equipos, profesionalización de operadores, protocolos mínimos de verificación y criterios de actuación conjunta entre seguridad privada y fuerzas públicas. En muchos países, todavía no existe una regulación robusta para el propio monitoreo, mucho menos para la IA que pretende intervenir en él.

Aceptar que una máquina interprete una alarma y decida un operativo policial exige un salto cultural profundo. Requiere que el Estado confíe, que el usuario confíe, que la industria confíe y que exista transparencia total sobre cómo decide la IA, con qué márgenes de error, con qué sesgos posibles y bajo qué auditoría permanente.

Un camino evolutivo más que una revolución repentina. Monitoreo de alarmas e inteligencia artificial no implica un apagón humano.

La adopción de IA en el monitoreo no ocurrirá como un “apagón humano”. Será un proceso gradual y estratificado. Un escenario razonable podría ser:

• 2025–2030: automatización completa del filtrado, priorización y verificación preliminar. El operador sigue siendo quien realiza el contacto policial.

• 2030–2035: autorización parcial para que la IA realice llamadas en eventos específicos y controlados, bajo auditoría posterior y con un humano disponible ante casos excepcionales.

• Desde 2035: primeras normativas que habilitan a una IA certificada a contactar directamente a fuerzas públicas en incidentes determinados, con trazabilidad completa y responsabilidad compartida entre actores.

No será un salto tecnológico; será un salto regulatorio.

El operador humano no desaparece: cambia de naturaleza

Con IA tomando tareas de filtrado, clasificación y hasta confirmación de eventos, el rol del operador se eleva. Ya no será un “atendedor de señales”, sino un analista de incidentes, un supervisor de modelos, un auditor de decisiones algorítmicas y un gestor de situaciones complejas donde el contexto social, emocional o humano define la acción.

La IA hará la parte repetitiva, estructurada y rápida.

El humano, la parte interpretativa, contextual y crítica.

¿Y los guardias privados? Una transformación similar

La IA y la automatización también modifican el rol del guardia en campo. Robots y sistemas autónomos asumirán tareas rutinarias, patrullajes simples, verificación perimetral y monitoreo de ambientes de riesgo. El guardia humano se concentrará en interacción social, resolución de conflictos, evaluación situacional y toma de decisiones con variables humanas.

Tal como ocurre con el operador, su trabajo no desaparece: se redefine.

La pregunta sobre monitoreo de alarmas e inteligencia artificial ya no es “si”, sino “cuándo”

El ecosistema del monitoreo está entrando en una nueva etapa, donde la automatización no solo optimiza procesos: redefine quién toma las decisiones críticas. La tecnología avanza más rápido que la regulación y mucho más rápido que la cultura institucional. El desafío es construir un marco que permita aprovechar ese avance sin perder responsabilidad, transparencia ni seguridad jurídica.

La inteligencia artificial ya está dentro de la central de monitoreo.

El próximo paso es decidir si también estará del otro lado del teléfono cuando haya que llamar a la policía.

Y cuando ese día llegue, no cambiará una función: cambiará toda la industria.